An der TU Berlin wird derzeit an einem Robotersystem geforscht, das den starren Ablauf klassischer Programme hinter sich lässt. Statt fixen Schritt-für-Schritt-Befehlen nutzt dieser Roboter ein Modell, das die Zusammenhänge in der Welt als Netzwerk versteht – und daraus selbstständig entscheidet, was zu tun ist.

Die Forschenden bringen dem System gewissermaßen bei, wie sich Dinge zueinander verhalten. Damit kann dem Roboter ein Ziel gegeben werden, etwa: „Die Schublade soll offen sein.“ Wie er dieses Ziel erreicht, plant und berechnet er dann laufend selbst.

Im Unterschied zu herkömmlichen Ansätzen, die jeden Griff und jede Bewegung präzise vorschreiben, bekommt dieser Roboter lediglich eine Zielbedingung.

Die Sequenz dazwischen – also wo er hinfährt, wie er greift und wann er zieht – wird nicht vorprogrammiert, sondern bei jedem Schritt neu entschieden. Das macht das System besonders geeignet für den Einsatz in echten Umgebungen, die voller Unsicherheiten stecken und sich ständig ändern. Denn genau dort stoßen starre Programme oft an ihre Grenzen.

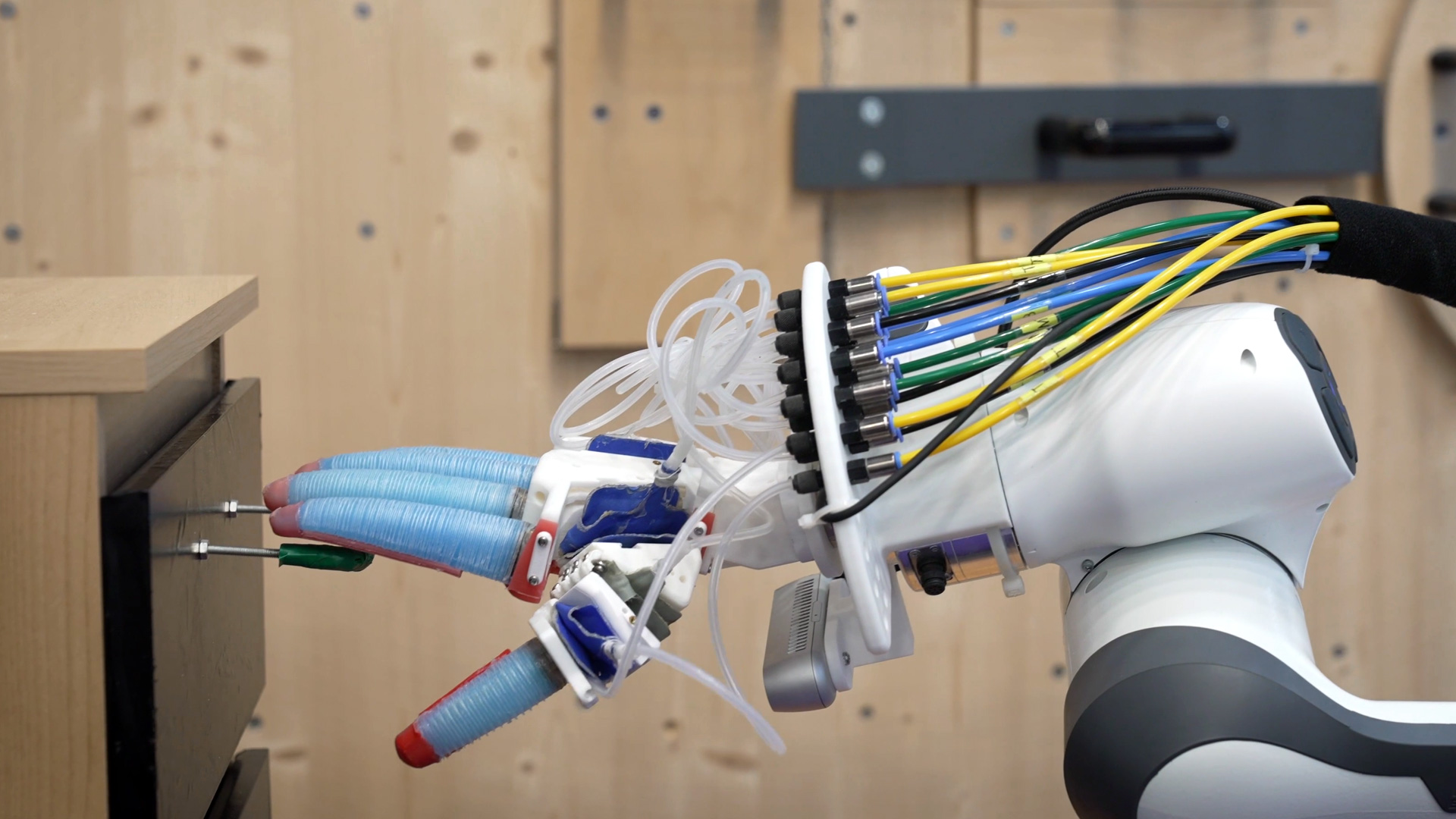

Ein Beispiel, das die Forschenden zeigen: Zunächst sucht der Roboter mit seinen Kameras eine grüne Schublade. Er verarbeitet Bilddaten, trianguliert die Lage und ermittelt so den Griffpunkt im Raum.

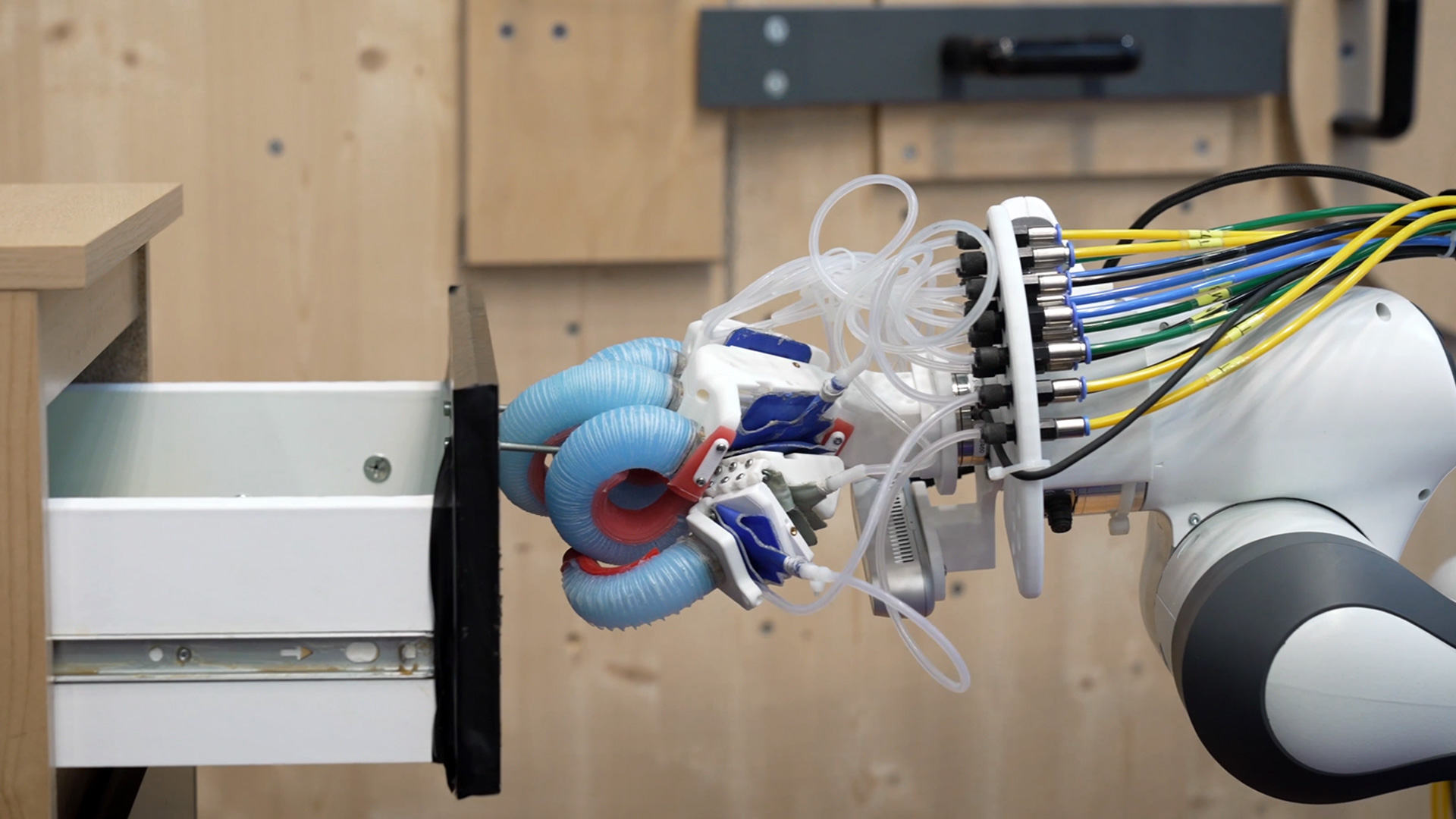

Hat er sich sicher positioniert, greift er zu und zieht die Schublade auf. Doch dabei bleibt es nicht: Sollte ihm die Schublade aus der Hand rutschen oder ein Mensch sie unerwartet wieder zuschieben, erkennt das System sofort, dass seine bisherige Vorstellung der Welt nicht mehr stimmt.

Es beginnt dann direkt erneut damit, den Griff zu lokalisieren und die Schublade nochmals zu öffnen. Diese Reaktion ist nicht fest einprogrammiert – sie ergibt sich dynamisch aus den internen Regeln und dem jeweils erkannten Zustand.

Damit unterscheidet sich der Ansatz deutlich von gängigen Machine-Vision-Algorithmen. Viele Systeme müssen Millionen Bilder von Schubladen und Greifvorgängen gesehen haben, um zu lernen, was zu tun ist. Die Berliner Lösung benötigt das nicht.

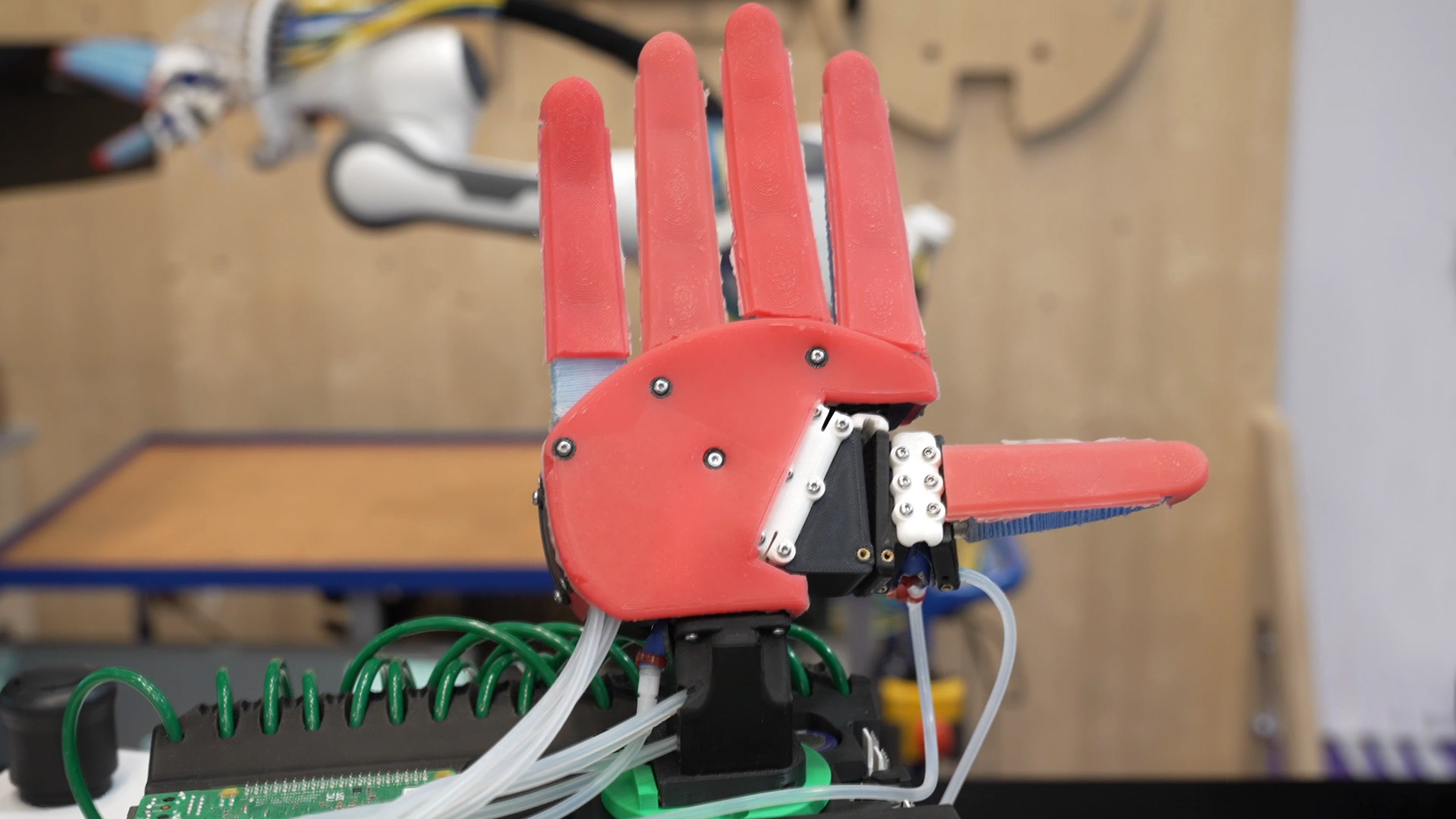

Sie nutzt stattdessen Graphen, die interne Abhängigkeiten darstellen, etwa dass eine Schublade nur geöffnet werden kann, wenn sie zuvor gegriffen wurde. Diese Logik reicht aus, um flexibel auf völlig neue Situationen zu reagieren, ohne dass der Roboter das exakte Szenario jemals zuvor gesehen haben muss.

Derzeit zeigen die Forschenden vor allem einfache Szenen: Der Roboter soll eine Schublade öffnen – und schafft das, auch wenn ihm jemand dabei die Arbeit erschwert. Doch der Ansatz ist auf mehr ausgelegt.

Denkbar sind längere, verschachtelte Aufgaben, bei denen etwa zunächst ein Objekt identifiziert und in die geöffnete Schublade gelegt werden soll. Hier experimentiert das Team noch, um solche Langzeitplanungen robust umzusetzen.

Spannend ist auch die Idee, dass Roboter ihre Abhängigkeitsgraphen künftig durch „Learning from Demonstration“ selbst erlernen könnten. Damit würden sie nicht mehr nur vordefinierte Regeln befolgen, sondern ihre Modelle aus Beobachtungen aufbauen – und könnten so noch vielseitiger auf neue Anforderungen reagieren.

Das Ziel ist letztlich ein Roboter, der verschiedenste Aufgaben erledigen kann, ohne jedes Mal neu programmiert werden zu müssen. Einer, der beim Öffnen von Schubladen, Einräumen oder anderen Handgriffen stets flexibel bleibt und auch mit unvorhergesehenen Störungen klarkommt.

So könnte die Robotik in Zukunft deutlich robuster und universeller werden – sei es in der Produktion, in der Pflege oder ganz einfach im Haushalt.